Lộ diện ‘quân bài’ giúp Nvidia giữ vững ngôi vương

Nvidia vừa cung cấp cái nhìn rõ ràng hơn về nền tảng tính toán AI dành cho trung tâm dữ liệu thế hệ mới mang tên Vera Rubin – một bước tiến được đánh giá có thể tạo ra ảnh hưởng sâu rộng đối với tương lai của trí tuệ nhân tạo, trong bối cảnh cả ngành đang phụ thuộc nặng nề vào công nghệ của hãng.

Vera Rubin từng được Nvidia nhắc đến trước đây, nhưng tại triển lãm công nghệ CES ở Las Vegas, công ty đã công bố chi tiết cách hệ thống hoạt động, cùng thời điểm ra mắt dự kiến.

Theo Nvidia, nền tảng này đang trong giai đoạn sản xuất và sản phẩm thương mại đầu tiên sẽ xuất hiện trong nửa cuối năm 2026.

Trong vài năm qua, Nvidia đã trở thành biểu tượng của cơn bùng nổ AI. Sự phổ biến của chip và nền tảng AI do hãng cung cấp đã đưa Nvidia vươn lên mốc 5.000 tỷ USD giá trị thị trường, mức cao nhất thế giới trong năm ngoái. Tuy nhiên, Nvidia cũng đối mặt sức ép ngày càng lớn: lo ngại về một “bong bóng AI”, sự trỗi dậy của đối thủ và xu hướng các tập đoàn công nghệ tự phát triển chip riêng để giảm phụ thuộc.

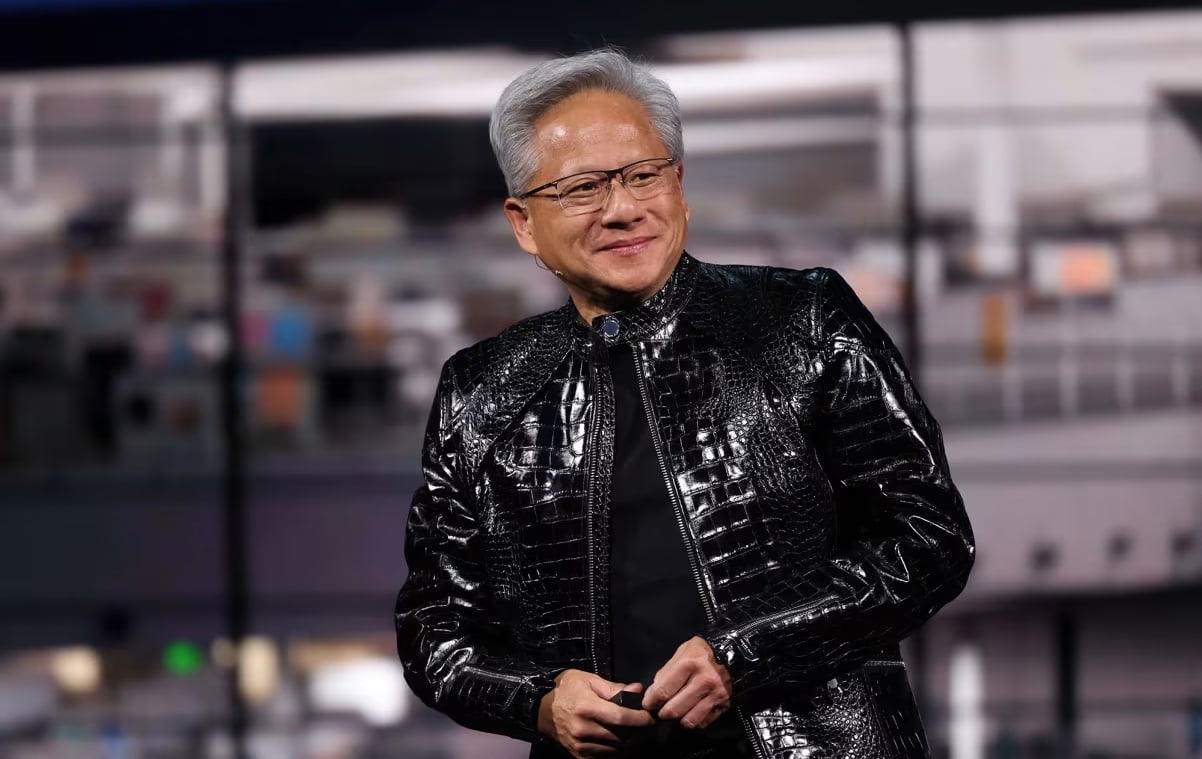

Tại sân khấu CES, trong chiếc áo da quen thuộc, CEO Jensen Huang trực tiếp đề cập câu hỏi mà giới đầu tư luôn ám ảnh: tiền đổ vào AI thực chất đến từ đâu? Theo ông, các doanh nghiệp đang chuyển ngân sách từ nghiên cứu – phát triển các phương pháp tính toán truyền thống sang trí tuệ nhân tạo.

“Người ta hỏi tiền từ đâu ra? Chính là từ đó mà ra”, Huang nói.

Vera Rubin – câu trả lời trước thách thức của AI thế hệ mới

Vera Rubin là nỗ lực nhằm giúp Nvidia tiếp tục giữ vị thế trung tâm trong kỷ nguyên AI ngày càng phức tạp. Các mô hình AI mới không chỉ cần sức mạnh tính toán lớn hơn mà còn đòi hỏi khả năng xử lý yêu cầu phức tạp, đa bước, giàu ngữ cảnh.

Nvidia tuyên bố máy chủ AI Vera Rubin NVL72 của họ “có băng thông còn lớn hơn toàn bộ Internet” – một tuyên bố cực kỳ táo bạo, phản ánh tham vọng của hãng.

Nền tảng này còn bao gồm một hệ thống lưu trữ hoàn toàn mới, giúp các mô hình AI xử lý khối lượng thông tin khổng lồ và ngữ cảnh dày đặc nhanh hơn nhiều so với các hệ thống hiện nay. Nvidia thẳng thắn chỉ ra rằng những giải pháp lưu trữ và bộ nhớ truyền thống, thậm chí cả GPU đang vận hành các trung tâm dữ liệu hiện tại, sẽ không còn đủ khi thế giới chuyển từ chatbot đơn giản sang trợ lý AI toàn diện.

Jensen Huang đã trình diễn trực tiếp sự chuyển đổi đó. Trong video minh họa, một người dùng kết nối một robot để bàn thân thiện với nhiều mô hình AI chạy trên máy tính DGX Spark. Kết quả là robot có thể đọc to danh sách việc cần làm của chủ nhân, thậm chí… ra lệnh cho chú chó trong nhà xuống khỏi ghế sofa.

Theo Huang, vài năm trước điều này là không tưởng, còn hiện tại lại trở nên “vô cùng đơn giản” nhờ sự ra đời của các mô hình ngôn ngữ lớn thay thế cách lập trình truyền thống.

Ông nhấn mạnh cách làm cũ đã lỗi thời khi AI ngày càng biết suy luận, chia nhỏ nhiệm vụ thành nhiều bước. Giờ đây, điểm nghẽn không còn nằm ở năng lực tính toán thuần túy mà là quản lý ngữ cảnh – yếu tố quyết định để AI hiểu và xử lý các yêu cầu phức tạp.

“Lưu trữ không thể còn là yếu tố thứ yếu nữa”, Dion Harris, Giám đốc cấp cao phụ trách giải pháp AI quy mô lớn tại Nvidia, khẳng định.

Ngay trước CES, Nvidia cũng công bố thỏa thuận cấp phép với công ty Groq – đơn vị nổi tiếng trong lĩnh vực suy luận AI. Điều đó cho thấy hãng đang đặt cược mạnh mẽ vào giai đoạn AI không chỉ đưa ra câu trả lời duy nhất, mà thực sự “suy nghĩ” và lập luận trong quá trình xử lý.

“Thay vì chỉ trả lời một lần, suy luận giờ đây là cả một quá trình tư duy,” Huang nói.

Theo Nvidia, các “ông lớn” điện toán đám mây như Microsoft, Amazon Web Services, Google Cloud và CoreWeave sẽ là những đơn vị đầu tiên triển khai Vera Rubin. Các tập đoàn công nghệ như Dell và Cisco dự kiến tích hợp nền tảng này vào trung tâm dữ liệu, trong khi các phòng thí nghiệm AI hàng đầu như OpenAI, Anthropic, Meta và xAI nhiều khả năng sẽ sử dụng để huấn luyện mô hình, đồng thời nâng chất lượng câu trả lời.

Không chỉ AI trung tâm dữ liệu, Nvidia còn mở rộng tham vọng sang lĩnh vực xe tự hành và robot. Hãng giới thiệu các nền tảng mới như Alpamayo và khái niệm “physical AI” – loại AI vận hành trong thế giới vật lý, điều khiển máy móc và thiết bị thực. Đây là sự tiếp nối tầm nhìn Nvidia từng công bố tại hội nghị GTC hồi tháng 10.

Áp lực vượt kỳ vọng và câu hỏi về nhu cầu thực sự

Tuy nhiên, vị thế dẫn đầu cũng đồng nghĩa với gánh nặng khổng lồ. Nvidia phải liên tục chứng minh tốc độ tăng trưởng đủ mạnh để thỏa mãn kỳ vọng phố Wall, đồng thời trấn an lo ngại rằng chi tiêu cho hạ tầng AI đang vượt xa nhu cầu thực tế.

Meta, Microsoft và Amazon đã chi hàng chục tỷ USD chỉ riêng trong năm nay. McKinsey dự báo doanh nghiệp toàn cầu sẽ đầu tư gần 7.000 tỷ USD vào hạ tầng trung tâm dữ liệu đến năm 2030. Không ít chuyên gia cảnh báo hiện tượng “vòng vốn khép kín”, khi chỉ một nhóm nhỏ công ty liên tục bơm tiền cho nhau để nuôi hệ sinh thái AI.

Song song đó, Google và OpenAI đang nỗ lực phát triển chip riêng, giúp họ kiểm soát tốt hơn và tối ưu phần cứng cho mô hình của mình. Nvidia cũng phải đối đầu với sự cạnh tranh ngày càng quyết liệt từ AMD, trong khi Qualcomm đã tuyên bố bước chân vào lĩnh vực trung tâm dữ liệu.

“Không ai muốn bị phụ thuộc hoàn toàn vào Nvidia”, Ben Barringer, Giám đốc nghiên cứu công nghệ toàn cầu tại Quilter Cheviot, từng nhận định khi nói về nỗ lực của các hãng công nghệ khác. “Họ đang cố gắng đa dạng hóa hệ sinh thái chip của mình”.

Dù chịu sức ép lớn, Nvidia vẫn đang ở vị thế mà không đối thủ nào dễ dàng thay thế. Vera Rubin là minh chứng cho nỗ lực duy trì lợi thế đó – một nền tảng vừa mang tính phòng thủ trước các đối thủ, vừa mở ra thế hệ AI mới mạnh mẽ hơn, thông minh hơn và gần với trí tuệ con người hơn.

Trong bối cảnh cuộc đua AI ngày càng căng thẳng, câu hỏi lớn không chỉ là công nghệ sẽ tiến xa đến đâu, mà còn là liệu nhu cầu thực và khả năng sinh lợi có theo kịp tốc độ đầu tư hay không. Nhưng ít nhất lúc này, Nvidia vẫn đang là tâm điểm của cuộc cách mạng trí tuệ nhân tạo toàn cầu và Vera Rubin chính là quân bài tiếp theo mà hãng đặt lên bàn.

Nguồn: VietnamFinance

.png)